kaggle(www.kaggle.com/)의 Intermediate Machine Learning 코스를 정리한 내용입니다.

자체 번역으로 공부하다보니 의미가 제대로 전달되지 않은 부분이 있을 수 있습니다.

잘못된 내용, 의견을 나눠보고 싶은 내용, 오타 등이 있다면 편하게 댓글로 남겨주세요 =)

1. Missing Values - 결측치

Three Approaches

1) 결측치가 있는 열 전체 삭제

가장 쉬운 방법이지만 중요한 데이터가 담긴 열에 소수의 결측치가 있을 경우 열 전체가 삭제되는 단점이 존재한다.

cf. NaN? Not a Number. 표현 불가능한 수치형 결과

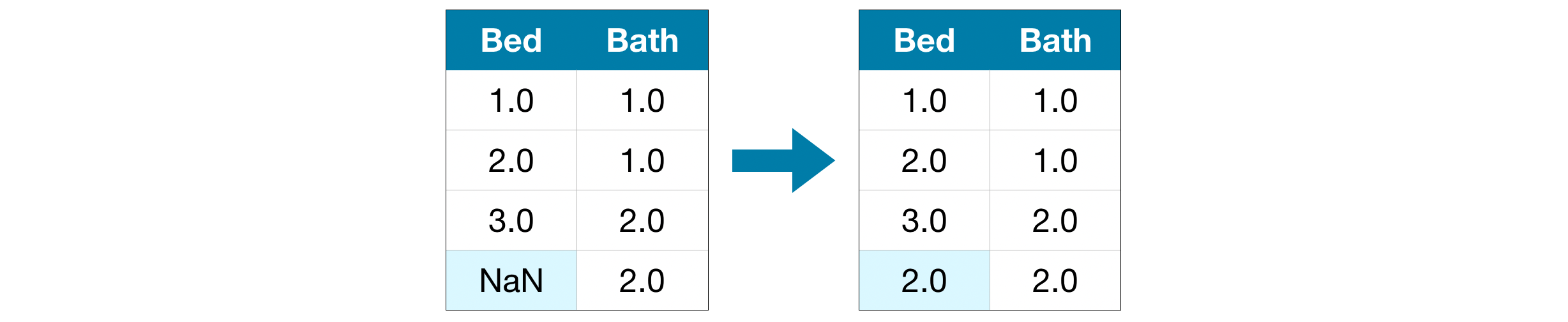

2) 대치(Imputation)

결측치를 특정 값으로 대체하는 방법으로 위의 사진은 평균값을 이용해 값을 채운 모습이다. 많은 경우 대체값이 완벽하게 맞아떨어지는 것은 아니지만 열 전체를 삭제하는 방법보다는 높은 정확도를 얻을 수 있다.

사이킷런에서 제공하는 SimpleImputer 모듈을 이용해 손쉽게 계산이 가능하다.

3) 대치의 확장

2)의 경우에서 결측치의 위치를 표시하는 열을 추가하는 방법이다. kaggle 사이트에는 'In some cases, this will meaningfully improve results. In other cases, it doesn't help at all.' 라고 나와있는데 저 문장에서 말하는 some cases와 other cases가 정확히 어떤 경우인지는 모르겠다 🤔

2. Categorical Variables - 범주형 변수

Categorical Variables

조사 대상을 특성에 따른 범주로 구분하여 측정된 변수로, 질적 변수라고도 한다. 예를 들어 동물=0, 식물=1이라고 할 때 0.5는 의미가 없는 값이며 두 변수 간의 연산은 무의미하기 때문에 연산이라는 개념을 적용할 수 없다.

Three Approaches

1) 범주형 변수 삭제

데이터셋으로부터 범주형 변수를 삭제하는 방법은 열이 중요한 정보를 담고 있지 않을 때만 유용한 방법이다.

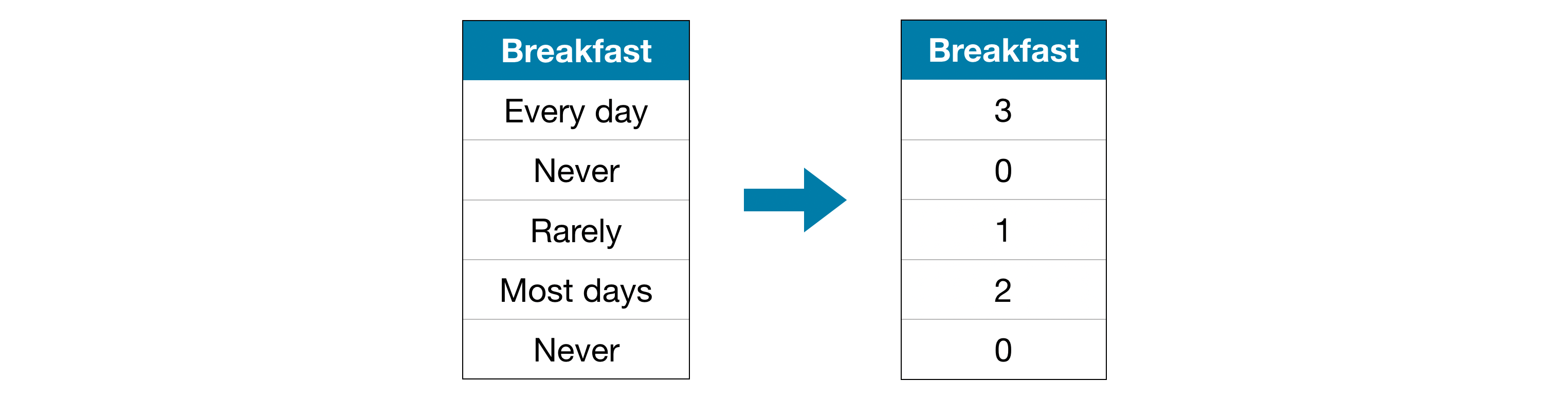

2) 라벨 인코딩

단어나 글자를 숫자 형태로 바꿔주는 작업으로 각각의 항목에 고유한 숫자를 붙이고 순서를 부여하는 방식으로 생각하면 된다. 위의 사진에서는 Never(0) < Rarely(1) < Most days(2) < Every day(3)의 순서가 적용된다.

3) ⭐ One-Hot Encoding

자연어 처리에서 문자를 숫자로 바꾸는 대표적인 기법으로 각 단어에 고유한 인덱스를 부여한 후 표현하고자 하는 단어의 인덱스 위치에는 1, 아닌 곳은 0을 부여하는 방식이다. 한 줄로 요약하면 해당되는 하나의 데이터는 1, 그렇지 않은 데이터는 0으로 채워주는 것이다. 일반적으로 범주형 변수의 종류가 많을 때는 이 방식이 잘 동작하지 않는다.

3. Pipelines

Introduction

파이프라인을 사용해서 얻을 수 있는 장점은

- 깔끔한 코드

- 적은 버그

- 쉬운 생산화

- 모델 검증을 위한 다양한 옵션

리스트 형태로 넣었을 때 글자 크기 조절 안되는 거 너무 불-편

Construct the full pipeline

① 전처리 단계(결측치 처리 및 범주형 데이터에 one-hot encoding 적용)

② 모델 정의

③ 파이프라인 생성 및 평가

4. Cross-Validation - 교차 검증

데이터를 folds라는 단위로 나누고 각 폴드마다 테스트해보면서 모델의 성능을 평가하는 과정이다.

교차 검증 과정은 모델의 성능 측정에 있어서 좀 더 높은 정확도를 제공하지만 모델을 여러 번 평가하기 때문에 시간이 오래 걸린다는 단점이 있다.

5. XGBoost

Introduction

앙상블 기법인 gradient Boosting의 단점을 보완하기 위해 나온 결정 트리 기반 모델

Gradient Boosting

간단하게 정리하면 단일 모델에 다른 모델을 반복적으로 결합시키는 앙상블 기법이다. 진행 과정은 아래 사진과 같다.

Parameter Tunning

XGBoost에는 정확도와 학습 속도에 드라마틱한 영향을 주는 몇몇 파라미터들이 있는데 각 파라미터에 대해 알아보도록 하자.

1) n_estimators

모델링 사이클(바로 위의 사진)의 반복 횟수를 지정한다. 앙상블에 포함시키는 모델의 수와 동일하며 너무 낮을 경우에는 언더피팅을, 너무 톺을 경우에는 오버피팅을 발생시키기 때문에 일반적으로 사용되는 수치는 100~1000이다.

2) early_stopping_rounds

n_estimators의 이상적인 값을 자동으로 찾을 수 있도록 한다. 지정한 값 이후의 반복에서 평가 지표의 개선이 없을 경우 모델을 멈추게 하는 값으로 early_stopping_rounds 값을 10으로 지정했다면 10번의 반복 후에도 성능이 좋아지지 않으면 모델 학습을 멈추는 것이다.

반복 횟수를 늘려도 성능이 나아지지 않는데 무의미한 학습을 계속 함으로써 생기는 시간 낭비를 방지해준다.

3) learning_rate

작은 학습률과 큰 estimators 값은 XGBoost 모델의 결과를 좀 더 정확하게 만든다. 디폴트로 지정된 학습률은 0.1이다.

4) n_jobs

데이터셋이 클 경우 parallelism을 이용해 속도를 향상시키기 위한 목적으로 사용된다. 컴퓨터의 코어 수와 동일하게 설정해주는 것이 일반적이고 데이터셋이 작은 경우에는 도움이 되지 않는다.

6. Data Leakage

Target Leakage

예측기가 예측을 만드는 순간에 이용할 수 없는 데이터를 포함하고 있을 때 발생하는 데이터 누수

Train-Test Contamination

학습 데이터와 검증 데이터를 명확하게 구별해놓지 않았을 때 발생하는 누수

'👩💻' 카테고리의 다른 글

| [ART] adversarial_training_mnist.ipynb 코드 분석 (0) | 2022.01.12 |

|---|---|

| [ART] ART for TensorFlow v2 - Callable 코드 분석 (0) | 2022.01.03 |

| [ART] ART for TensorFlow v2 - Keras API 코드 분석 (0) | 2021.12.31 |

| [DACON] 코드 분석 - MNIST : 숫자 이미지 분류 (0) | 2021.05.25 |

| [kaggle] Intro to Machine Learning (0) | 2021.04.26 |