3장 이름이 사이킷런을 타고 떠나는 머신 러닝 분류 모델 투언데 뭔가 귀엽다 ㅋㅋㅋ

계속 임시저장이었다가 드디어 올리는,,,ㅎ 머쓱 〜( ̄▽ ̄〜)(〜 ̄▽ ̄)〜

✔ 3.1 분류 알고리즘 선택

분류 모델의 예측 성능과 계산 성능은 학습에 사용하려는 데이터에 크게 의존

< 머신러닝 알고리즘을 훈련하기 위한 다섯 가지 주요 단계 >

1️⃣ 특성을 선택하고 훈련 샘플 모집

2️⃣ 성능 지표 선택

3️⃣ 분류 모델과 최적화 알고리즘 선택

4️⃣ 모델의 성능 평가

5️⃣ 알고리즘 튜닝

✔ 3.2 사이킷런 첫걸음

사이킷런 라이브러리 : 다양한 학습 알고리즘 제공, 데이터 전처리나 세부 조정, 모델 평가를 위해 편하게 사용할 수 있는 함수 多

⭐ 사이킷런이 제공하는 머신러닝 API

- Classification : 분류 알고리즘 구현 클래스

- Regression : 회귀 알고리즘 구현 클래스

- Classification + Regression => Estimator 클래스라고 부름

- Clustering

- Dimensional reduction

- Model selection

- Preprocessing

from sklearn import datasets

import numpy as np

iris = datasets.load_iris()

X = iris.data[:, [2, 3]]

y = iris.target

# np.unique(y)는 iris.target에 저장된 세 개의 고유한 클래스 레이블 반환

print('클래스 레이블 :', np.unique(y))output

클래스 레이블: [0 1 2]붓꽃 클래스 레이블(이름)인 Iris-setosa, Iris-versicolor, Iris-virginica가 0 1 2 로 저장

👉 정수 레이블은 사소한 실수를 피할 수 있고 메모리 영역을 적게 차지하기 때문에 권장됨

✔ 3.3 로지스틱 회귀(회귀 X, 분류 모델 O)를 사용한 클래스 확률 모델링

퍼셉트론 규칙 → 클래스가 선형적으로 구분되지 않을 때 수렴할 수 없다는 큰 단점

3.3.1 로지스틱 회귀의 이해와 조건부 확률

로지스틱 회귀 : 구현이 쉽고 선형적으로 구분되는 클래스에 뛰어난 성능을 내는 분류 모델(이진 분류를 위한 선형 모델이지만 다중 분류로 확장 가능)

❔ odds ratio

P/(1-P) → P는 양성 샘플일 확률, 양성 샘플은 좋은 것을 의미하는 게 아니라 예측하려는 대상을 나타냄

❔ logit(P) : 로짓 함수, odds ratio에 로그 함수(로그 오즈)를 취한 형태 → 0과 1 사이의 입력 값을 받아 실수 범위 값으로 변환

❔ 특성의 가중치 합과 로그 오즈 사이의 선형 관계

* P(y=1|x) 는 특성 x가 주어졌을 때 이 샘플이 클래스 1에 속할 조건부 확률

* 로짓 함수를 z(=w^{T}x)에 대해 정리한 함수 : (logistic) sigmoid function

import matplotlib.pyplot as plt

import numpy as np

def sigmoid(z):

return 1.0 / (1.0 + np.exp(-z))

z = np.arange(-7, 7, 0.1)

phi_z = sigmoid(z)

plt.plot(z, phi_z)

plt.axvline(0, 0, color='k')

plt.ylim(-0.1, 1.1)

plt.xlabel('z')

plt.ylabel('$\phi (z)$')

# y축 눈금과 격자선

plt.yticks([0.0, 0.5, 1.0])

ax = plt.gca()

ax.yaxis.grid(True)

plt.tight_layout()

plt.show()

❔ 아달린과 로지스틱 회귀 차이점

최종 입력을 한 뒤, 가중치를 다시 계산하는 과정에서 필요한 활성화 함수 차이

👉 아달린 알고리즘은 선형 활성화 함수 / 로지스틱 회귀 알고리즘은 시그모이드 활성화 함수

3.3.2 로지스틱 비용 함수의 가중치 학습

아달린 분류 모델 : 제곱 오차합 비용 함수 최소화하는 가중치 w를 학습

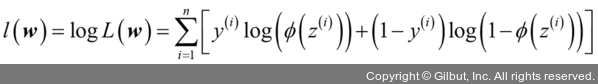

L(w)의 자연 로그를 최대화하는 것이 더 쉬움 -> logL(w) 로그 가능도 함수

cf. 로그 가능도 함수를 최대화하는 것이 더 쉬운 이유

1️⃣ 로그 함수 적용 시 가능도가 매우 작을 때 일어나는 수치 상의 underflow를 사전 방지 가능

2️⃣ 계수 곱을 계수 합으로 바꿀 수 있음

3.3.3 아달린 구현을 로지스틱 회귀 알고리즘으로 변경

로지스틱 회귀 구현 → 아달린 구현 비용 함수를 새로운 비용 함수로 바꿔주면 O

새로운 비용 함수 이용해서

1️⃣ 에포크마다 모든 훈련 샘플을 분류하는 비용 계산

2️⃣ 선형 활성화 함수를 시그모이드 활성화로 변경

3️⃣ 임계 함수가 클래스 레이블 -1과 1이 아닌 0과 1을 반환하도록 변경

👉 세 단계 반영하면 로지스틱 회귀 모델 얻을 수 있음

❌ p.97 로지스틱 모델로 붓꽃 결정 경계 그리기 error

'Artificial Intelligence > Studying' 카테고리의 다른 글

| Logistic regression (0) | 2020.12.29 |

|---|---|

| Gradient descent (0) | 2020.11.14 |

| Linear regression (0) | 2020.11.14 |

| [머신러닝 교과서] Ch04 좋은 훈련 세트 만들기 : 데이터 전처리 (0) | 2020.11.01 |

| [머신러닝 교과서] Ch02 객체지향 퍼셉트론 API 분석 (0) | 2020.09.20 |